2026年1月1日,DeepSeek团队于arXiv平台发布重磅研究成果,提出全新mHC(流形约束超连接)架构,针对大模型训练中的拥堵与稳定性难题实现根本性突破,为行业从“规模竞赛”转向“效率革命”提供核心技术支撑,引发全球AI领域对底层架构创新的广泛关注。

当前大模型产业深陷核心矛盾:随着参数规模飙升至千亿级以上,传统训练架构的弊端愈发凸显。分布式训练中的高频数据交互导致带宽饱和,某头部企业GPU集群训练时实际负载仅45%,大量算力被浪费;同时,传统超连接(HC)架构虽能拓宽信息通道,却破坏残差连接核心属性,易引发梯度爆炸,Meta在Llama 2研发中便因此被迫回退方案。公开数据显示,2025年千亿参数模型单次训练成本超千万美元,30%以上源于拥堵造成的损耗。

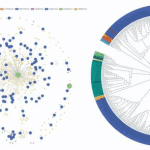

mHC架构的核心创新在于双重数学约束:通过谱范数约束将连接矩阵最大奇异值控制在1以内,从根源规避信号过度放大;借助双重随机矩阵约束恢复信号守恒特性,相当于为神经网络铺设智能交通调度系统。实测数据显示,该架构在27B参数模型测试中,8项核心下游任务全面超越传统HC架构,BBH任务得分从48.9分提升至51.0分,DROP任务从51.6分提升至53.9分,信号增益精准控制在1.6的理想区间,损失曲线全程平稳收敛。

其工业价值尤为突出:训练内存占用降低40%,迭代效率提升25%,扩展率n=4时额外训练开销仅6.7%,工程优化后可忽略不计。某AI初创企业采用该架构训练10B参数模型,硬件成本从53.5万美元骤降至26.7万美元,周期缩短三分之一;在三甲医院医疗影像项目中,训练速度提升20%且无梯度消失问题。对于算力有限的中小企业而言,这一技术大幅降低了大模型研发门槛。

行业专家指出,mHC架构的发布标志着大模型进入“架构精细化设计”阶段,打破了性能与稳定性不可兼得的固有认知。DeepSeek创始人梁文锋表示,团队正将该架构集成至下一代大模型,预计将在长文本处理与复杂推理任务中实现更大突破。随着技术开源落地,有望重构产业成本结构,为百万亿级参数模型训练奠定基础,推动全球AI向更高效、普惠方向演进。

苏公网安备32021302001419号

苏公网安备32021302001419号